Логи сервера – это важный инструмент для анализа работы веб-сайта. Они содержат информацию о каждом запросе, поступающем на сервер, а также о всех ошибках и проблемах, возникающих при обработке запросов. Анализ логов сервера позволяет выявлять различные проблемы, включая проблемы с индексацией и обходом сайта.

Проблемы с индексацией и обходом сайта могут привести к тому, что поисковые системы не смогут найти и проиндексировать все страницы сайта. Это может означать, что часть контента не будет видна для пользователей через поисковые системы, что в свою очередь может негативно сказаться на посещаемости и популярности сайта.

Для определения проблем с индексацией и обходом сайта можно изучить логи сервера. В логах сервера можно найти информацию о том, какие страницы обращаются поисковые системы, какие страницы не были проиндексированы, а также о возможных проблемах с доступностью и структурой сайта. Анализ логов сервера помогает выявить и устранить возникающие проблемы, чтобы поисковые системы могли полностью проиндексировать все страницы сайта.

Как найти проблемы с индексацией и обходом сайта в логах сервера

Первым шагом при поиске проблем с индексацией и обходом сайта в логах сервера является анализ структуры и содержимого этих логов. Важно обратить внимание на коды статуса, которые предоставляют информацию о том, была ли страница успешно обследована поисковым роботом или возникли какие-либо проблемы в процессе обхода.

Использование инструментов анализа логов сервера

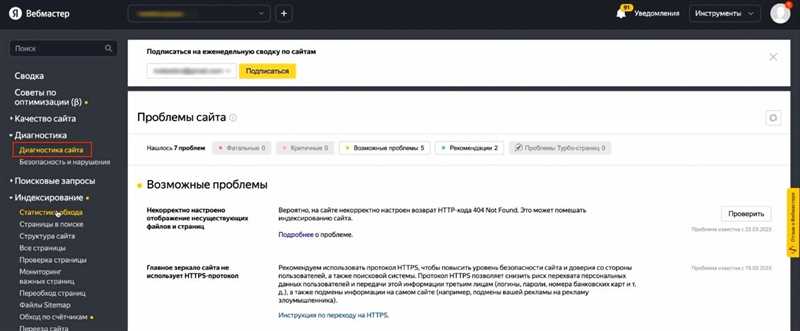

Для удобного анализа логов сервера можно воспользоваться различными инструментами. Один из них — это Google Search Console. С помощью этого бесплатного сервиса можно просмотреть запросы, в результате которых сервер выдал страницы, а также информацию о том, какие страницы были обследованы поисковым роботом и какие статусы запросов.

Также полезным инструментом является Screaming Frog SEO Spider. Он позволяет анализировать логи сервера и выявлять проблемы с индексацией и обходом сайта. С помощью этого инструмента можно проверить, есть ли на сайте страницы с ошибочными кодами статуса, такие как 404 (страница не найдена) или 500 (внутренняя ошибка сервера).

Оптимизация файла robots.txt и карты сайта

Еще одним способом решения проблем с индексацией и обходом сайта является оптимизация файла robots.txt и создание карты сайта. В файле robots.txt можно указать инструкции для поисковых роботов, например, запретить обход некоторых разделов сайта, если они не должны быть проиндексированы. Карта сайта (sitemap.xml) предоставляет поисковым роботам информацию о структуре сайта и помогает им обходить его более эффективно.

Анализ логов сервера для определения проблем с индексацией

Одной из главных проблем, связанных с индексацией сайта, является наличие ошибок 4xx и 5xx. Ошибки 4xx указывают на проблемы с запросами, такие как «404 Not Found» (страница не найдена) или «403 Forbidden» (доступ запрещен). Ошибки 5xx свидетельствуют о проблемах на стороне сервера, например, «500 Internal Server Error» (внутренняя ошибка сервера) или «503 Service Unavailable» (сервис недоступен).

Одним из способов использования логов сервера для определения проблем с индексацией является поиск кодов ответа 4xx и 5xx в логах. Также стоит обратить внимание на запросы с ошибками 301 и 302, которые свидетельствуют о редиректах. Подобные ошибки могут привести к неправильной индексации сайта поисковыми системами.

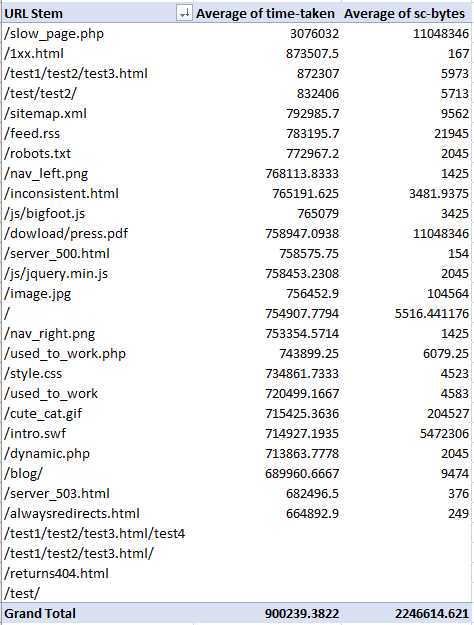

Другими важными аспектами анализа логов сервера являются поиск повторных запросов (например, запросов от ботов, которые могут вызывать проблемы с индексацией) и проверка скорости ответа сервера. Медленная скорость ответа сервера может отрицательно сказываться на процессе индексации сайта.

Определение причин, по которым роботы не могут обойти сайт

Одной из причин, по которым роботы не могут обойти сайт, является наличие ошибок в файле robots.txt. Этот файл используется для указания роботам, какие страницы сайта они могут индексировать. Если в файле robots.txt есть ошибки или некорректные указания, то роботы могут не обойти определенные разделы сайта, что может привести к пропуску важной информации.

Еще одной возможной причиной проблем с обходом сайта роботами может быть использование неправильных метатегов на страницах сайта. Метатеги, такие как «noindex» или «nofollow», указывают роботам, что страницу нужно исключить из индекса или не следовать по ссылкам на этой странице. Если такие метатеги неправильно установлены или используются не на тех страницах, где это нужно, то это может привести к проблемам с обходом сайта.

Также, причинами проблем с обходом сайта можно назвать ограничения, установленные на сервере. Например, если сервер установил ограничение на частоту запросов или на количество одновременных подключений, то это может привести к тому, что роботы не смогут полностью обойти сайт, так как они не смогут получить доступ ко всем его страницам в заданное время.

В логах сервера можно найти информацию о запросах от роботов и ошибки, которые они встретили при обходе сайта. Анализ этих данных позволит определить причины проблем с обходом сайта и принять меры для их исправления. Это важная задача для веб-мастеров, так как обход сайта роботами является важным этапом для его успешной индексации и продвижения в поисковых системах.

Решение проблем с индексацией и обходом сайта на основе анализа логов

1. Устранение ошибок доступа

Ошибки доступа (например, ошибка 404) указывают на то, что страница, указанная в логах, не существует или не доступна для роботов. Для исправления этой проблемы необходимо установить правильные перенаправления, создать страницы с ошибками 404 и проверить настройки сервера.

2. Работа с файлом robots.txt

Файл robots.txt позволяет указывать поисковым роботам, какие страницы они могут индексировать, а какие — нет. При анализе логов следует обратить внимание на возможные ошибки в файле robots.txt и устранить их.

3. Исправление ошибок 500

Ошибка 500 указывает на внутреннюю ошибку сервера. Для решения этой проблемы необходимо просмотреть логи ошибок и выяснить причину ошибки. Часто ошибки 500 связаны с проблемами в коде сайта или в настройках сервера.

4. Изменение URL-адресов

Если логи сервера указывают на неправильные URL-адреса, которые роботы не могут обойти, необходимо изменить эти адреса, чтобы они стали более понятными и легко доступными для индексации.

5. Проверка на дублирование контента

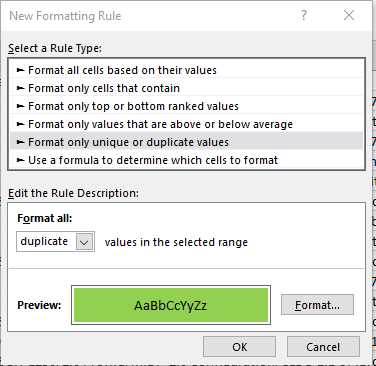

Анализ логов позволяет выявить дублирование контента, которое может негативно повлиять на индексацию и ранжирование сайта. Если такая проблема обнаружена, необходимо принять меры по устранению дублирования, например, добавить канонические ссылки или изменить контент страницы.

Заключение

Анализ логов сервера является важным инструментом для выявления проблем с индексацией и обходом сайта поисковыми роботами. На основе данных из логов можно принять меры по устранению ошибок доступа, настройке файла robots.txt, исправлению ошибок 500, изменению URL-адресов и борьбе с дублированием контента. Решение этих проблем позволит повысить видимость сайта в поисковых системах и улучшить его позиции в результатах поиска.

Наши партнеры: